Bonjour,

Lorsque l’on fait le design d’une infrastructure réseau, sur laquelle va transiter du stockage, il faut considérer certains points et respecter des best practices.

Premier point, la bande passante, pas de miracle, la préférence ira au 10Gb/s, mais pour les petites infrastructures, jusqu’à une cinquantaine de VMs, on peut utiliser des switchs 1Gb/s.

Avec un réseau de stockage à 1 Gb/s, les problèmes surviennent lors des backups, c’est là que l’on arrive, très facilement, à saturer les bandes passantes, c’est dans ce cas, que le respect systématique de l’ensemble des best practices est important. Ça peut vite faire une différence, notamment sur vos fenêtres de backup…

Voici quelques points à faire attention :

Des switchs avec de larges buffers, ce qui va permettre de gérer les congestions réseau, notamment sur les ports de la baie de stockage.

Faites attention aux ports 10Gb/s dédiés aux uplink que l’on retrouve sur des switchs Edge, avec une majorité de port 1Gb/s. Le ou les deux ports 10Gb/s, ont très peu de buffers et en cas de congestion, les performances risquent de s’écrouler

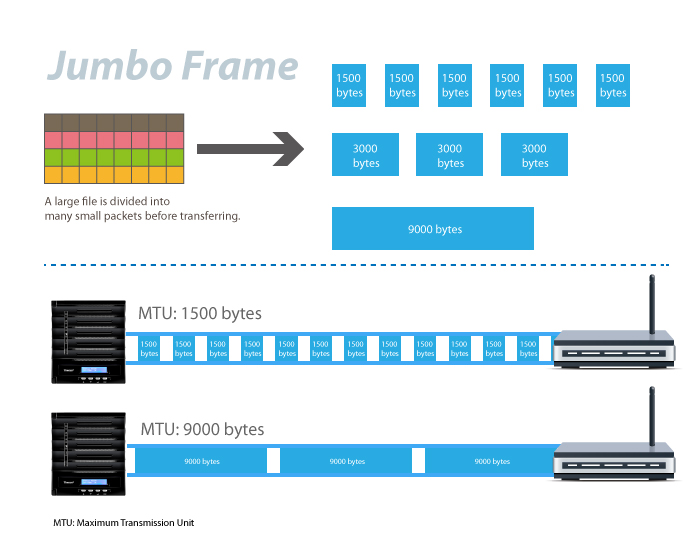

Le Jumbo frames qui offrira la possibilité d’envoyer des frames, traditionnellement limitées à 1500, de taille 9000. Ce qui diminuera drastiquement le nombre de packet envoyés sur le réseau. Avec un réseau 1Gb/s cela amènera 10 à 20 % de throughput supplémentaires, pour le 10Gb/s, ce sera le seul moyen de pouvoir saturer les liens. Attention, la configuration devra être de bout en bout, au risque d’avoir ses paquets dropés, par l’élément non configuré en MTU 9000.

Des switchs dédiés, obligatoire pour un réseau 1Gb/s, mais difficile à exiger, avec les switch 10Gb/s et leurs prix encore exorbitants, sans compter la mode du convergé. C’est là que les équipes réseau doivent comprendre que toutes actions, sur le réseau, deviennent extrêmement critiques et que les coupures sont strictement interdites. Nos Hyperviseurs et VMs ne le supporteront pas. L’architecture des switchs dépendra également du protocole utilisé.

Point important, on ne route jamais un réseau de stockage ! et pour éviter tout problème, ne configurez jamais de gateway.

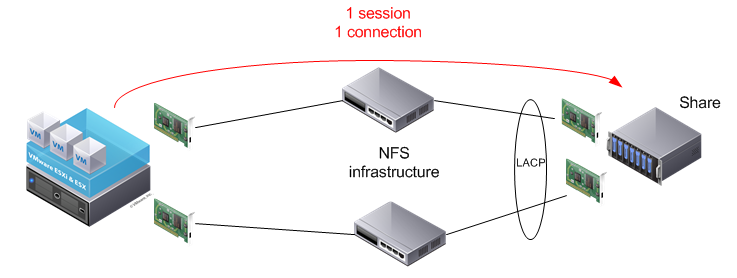

Pour le NFS, on aura tendance à stacker les switch, afin d’offrir un failover transparent, ceci dû à la faiblesse du protocole. En effet, pas de multipassing, ni failover. On a une session, une connexion donc même si tout est redondant, on ne pourra utiliser qu’une seul fois la bande passante. Le LACP va nous être utile pour le failover.

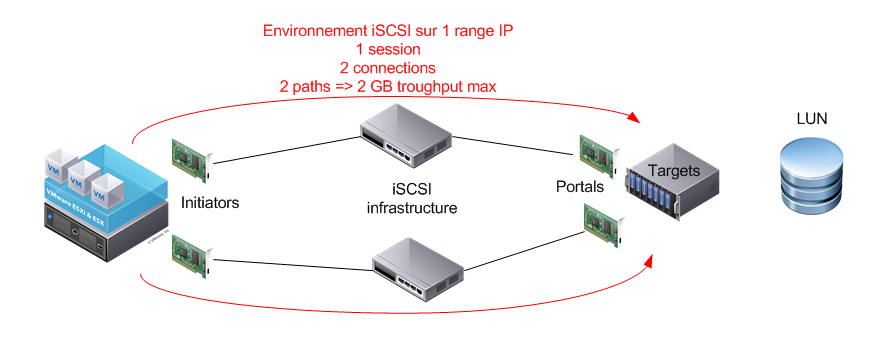

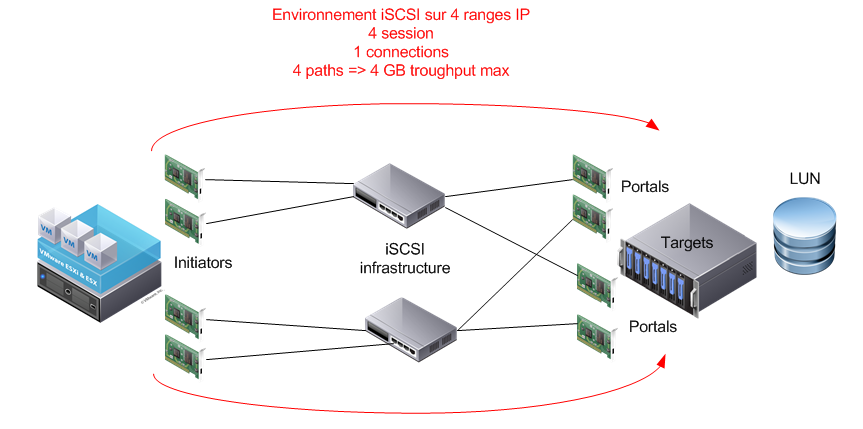

Pour l’iSCSI ou FCoE, on ne va pas stacker les switch, car on a l’avantage du MPIO, qui offre un multipathing et failover complétement transparents, et il va être capable d’utiliser tous les chemins à dispositions et donc toute la bande passante, là on a une session et de multiples connexions selon le nombre de chemins. C’est pour cela que je conseil d’utiliser du iSCSI lorsque les switch sont en 1Gb/s. et le LACP va être notre ennemi, car il tue les avantages du MPIO.

Voici un petit explicatif des différents composants d’une infrastrcture de stockage:

Target:

C’est le contrôleur de votre baie de stockage, on aura, en principe, minimum deux targets par baie.

Initiator:

C’est notre client de stockage c’est lui qui initie la connectivité avec la baie, et qui va permettre la communication des IO sur votre environnement de stockage.

Portal:

Ce sont les IP ou ports qui écoutent au niveau des targets.

Avec le software iSCSI initiator, on peut facilement ajouter des VMkernel et cartes réseaux liées, afin d’augmenter le nombre de connexion. Selon le nombre de target, à disposition, sur chaque contrôleur, on va ajouter le même nombre de VMkernel et cartes réseaux liées.

Autre conseil, configurez un subnet, avec son VLAN, par portal, pour recréer une notion de fabric et de zone que l’on a dans le monde du Fiber Channel.

On voit facilement les avantages, d’un bon design réseau et du respect systématique des best practices.

Bon stockage IP !